LSI - оптимізація без ключових слів

- Що таке LSI, і з чим їдять?

- Як поставити LSI на службу SEO?

- Як застосовувати LSI?

- Доповнення до статті, яка була її початком

Автор: Олексій Чекушіна - творець сервісу Just-Magic.org

Що таке LSI, і з чим їдять?

Говорячи простою мовою, LSI - це спосіб визначення тематики тексту за що містяться в ньому словами. Наприклад, якщо в документі зустрічаються слова «зимова», «протектор», «шпильки» - то, найімовірніше, це текст про шини. А якщо - «сковорода», «запікати», «соус» - то це щось, що відноситься до кулінарії.

... <Тут було довге й докладне наукове пояснення, що ж таке LSI, але через його нудності переносимо цю захоплюючу частину в кінець статті, щоб наші читачі не заснули на самому початку.> ...

Як поставити LSI на службу SEO?

Досвід показує, що LSI-тексти трохи краще ранжуються і набагато рідше потрапляють під спам-санкції. Однак, як проводити аналіз? Звідки взяти релевантні слова? Як оцінити текст на відповідність тематиці?

Добре, якщо копірайтер глибоко розбирається в питанні, тоді LSI-текст вийде сам собою. А що якщо немає? Тоді на допомогу повинна прийти автоматизація. Нижче поговоримо про чотирьох можливих підходах до неї:

Метод 1. Використання подсветок

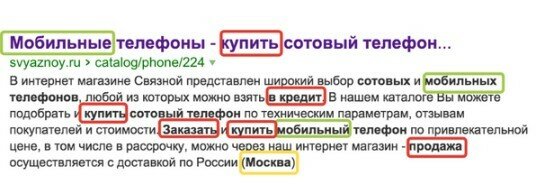

Це те, що лежить на поверхні, і тому легко використовується. Що підсвічує пошук? По-перше, це синоніми. По-друге, геоуказаніе (для геозалежних запитів) і по-третє, якісь тематичні слова. наприклад:

Зелена рамка виділені синоніми.

Жовтої - геоуказаніе.

І червоною - додаткові слова підсвічування.

Але скільки слів ми можемо «витягти» з висвітлює: від 3 до 5? Іноді трохи більше, але завжди менше десяти. Для повноцінного написання тематичного тексту це не годиться. Тому професіонали цей спосіб не використовують.

Метод 2. Підрахунок з використанням сторонніх колекцій

«Спарс весь інтернет» - завдання дорога, і для цілей LSI - те саме що забивання цвяхів мікроскопом. Адже тільки один обсяг даних складе не один десяток терабайт. Плюс, нам доведеться зіткнутися із завданням фільтрації спаму і дублів.

Можна спробувати використовувати вже готові колекції. Наприклад - корпус російської мови або тексти «Вікіпедії». Але тут серйозну роль починає грати специфіка колекції. Навряд чи літературні тексти або інформаційні статті Wikipedia допоможуть нам в написанні тексту для комерційної сторінки, що продає дизельні генератори.

Варто відзначити, що досить непогані результати отримав Рамблер, коли застосував методику LSI до своєї колекції пошукових запитів. Однак результати вийшли, скоріше, застосовні для розширення семантики, ніж для написання текстів.

Метод 3. Підрахунок на підставі топа Яндекса

Основна ідея підходу полягає в допущенні: якщо документи потрапили в топ Яндекса, значить вони тематично. І, загалом-то, це допущення в ряді випадків вірно. Але оскільки LSI-слова самі по собі є досить слабким фактором, то вже на середньо-конкурентних запитах ми часто будемо стикатися з неякісним топом. Як результат, спроба провести LSI аналіз призведе не до бусту сторінки, а тільки до копіювання чужих помилок.

До плюсів методу однозначно варто віднести простоту реалізації. Досить витягнути документи з топ-10 Яндекса і порахувати кількість входжень кожного слова в кожному з цих документів.

В якості основних мінусів підходу слід виділити непридатність по відношенню до середньо- і низько-конкурентних запитах.

Метод 4. Підрахунок з використанням всієї колекції Яндекса

Цей метод є найбільш точним, оскільки ми починаємо оперувати тією ж колекцією, що і Яндекс. Завантажувати інтернет не потрібно, більше того, Яндекс вже виконав за нас певну частину роботи, виключивши з пошуку безліч дублів і спаму. Для пошуку по своїй колекції він вже надав нам відмінні інструменти у вигляді мови пошукових запитів.

На чому ж побудований метод з використанням колекції Яндекса? Ми подаємо до Яндексу запити намагаючись побудувати 2 уніграммние мовні моделі:

- Модель породження слова запитом.

- Модель породження запиту словом.

Звучить складно, але насправді принцип тут - простий.

Модель породження слова запитом зводиться до відповіді на питання: якщо в документі зустрівся запит, яка ймовірність зустріти в ньому слово? Наприклад, якщо в документі зустрівся запит «шини bridgestone», яка ймовірність появи в ньому слова «зимова»?

Модель породження запиту словом зводиться до відповіді на питання: якщо в документі зустрілося слово, яка ймовірність зустріти в ньому запит? Наприклад, якщо в документі зустрілося слово «шипована», яка ймовірність виявити в ньому ж запит «зимова гума»?

На практиці для комплексної оцінки двох моделей виходить недостатньо, і необхідно використовувати третю - «нормалізує» модель, засновану на видаленні термінів і запиту один від одного. Це не відповідає принципам LSI, про які я писав вище, але необхідно при роботі з такою «брудної» колекцією як веб-документи, де змістовні тексти не пройшли очищення від «обв'язки» у вигляді меню / хедерів / футера та іншої службової інформації.

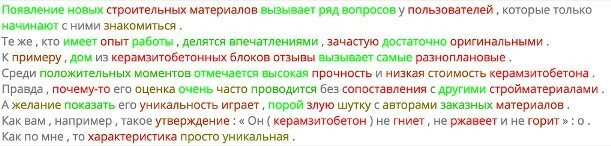

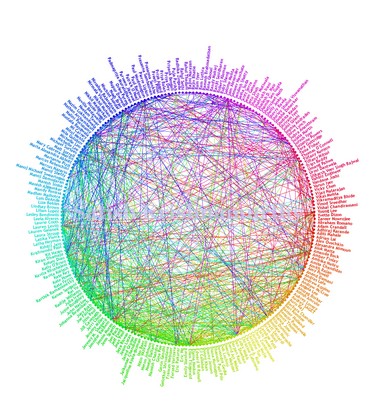

Саме на цьому методі побудовані модулі « акварель »І« Акварель-генератор " в системі Just-Magic.org . Досить кумедно спостерігати, як система працює з аналізом текстів. Наприклад, практично з будь-якого тексту вона готова зробити готовий словник спічрайтера Володимира Володимировича. Читайте тільки зелені слова:

(На скріншоті представлений аналіз тексту про керамзитобетонні блоки, який був проведений на вимогу «владимир путин»)

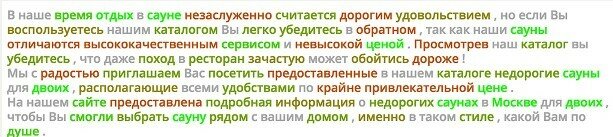

При цьому система практично не залежить від якості текстів в топі. Наприклад, ось як відпрацьовує за запитом «сауна на двох» аналізатор, заснований на топ-10:

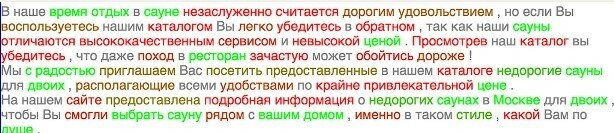

А ось як це робить «Акварель»:

Як можна помітити, «Акварель» «не піддалася» на часто зустрічаються в топі слова і забракувала їх, як нерелевантні. Також якість топа не позначається на результатах роботи «Акварель-генератора», який створює список релевантних слів і словосполучень. Ось приклади словосполучень, які він знаходить по даному запиту:

- романтична вечеря

- російська лазня

- фінська сауна

- турецького хамама

- комфортного відпочинку

- романтичного вечора

Незважаючи на явні плюси, подібний метод має і свої мінуси. По-перше, він дуже ресурсоемок: на перевірку одного слова витрачається 3 XML-запиту; а на складання списку за допомогою «Акварель-генератора» йде в середньому 2300 XML-запитів. У підсумку перевірка таким способом виходить значно дорожче інших, які сьогодні доступні практично безкоштовно.

По-друге, метод чутливий до середнього якості колекції текстів в інтернеті. Наприклад, для запиту «синхрофазотрон» він визначить слово «є» як дуже релевантне, через те, що фраза «не всякий синхрофазотрон є коллайдером», часто зустрічається в інтернеті. Ну а спроба створити / перевірити інформаційну статтю за запитом «фарбування бампера ваз» свідомо приречена на провал через засилля комерційних текстів по даному запиту.

Як застосовувати LSI?

На практиці застосування підходу LSI може використовуватися в двох випадках: коли є необхідність простимулювати додатковий «стусан» по висококонкурентних запитах і забезпечити захист сайту від текстового спам-фільтра.

Чому так виходить? LSI-слова - досить слабкий фактор в порівнянні з тими ж входженнями, тому до них слід звертатися, коли вся базова оптимізація вже проведена. Як її робити я детально описував в своїй статті « непорочне просування ».

За висококонкурентних запитах нам доводиться «тиснути» відразу всіма чинниками, бо в умовах великого їх числа і нормалізації кожного (приведення в інтервал від 0 до 1) результат по ВК-запитам буде тільки при оптимізації всіх речей, до яких можемо дотягнутися.

Що ж стосується захисту від спам-фільтрів, то це основне завдання, заради якої замислювалася система. В спам-алгоритмах LSI має куди більш значну вагу, ніж в ранжируванні. І якщо ваш сайт вже потрапив під санкції - переписування текстів за допомогою «Акварелі» або аналогічних LSI-інструментів дозволяє вийти з під санкцій. А початкове їх написання з використанням LSI - не дає під них потрапити.

Доповнення до статті, яка була її початком

Що ховається під абревіатурою LSI?

Якщо пояснювати простою мовою, LSI - це спосіб визначення тематики тексту і угруповання текстів по тематичність. Метод заснований на аналізі взаємозв'язків між колекцією документів і термінами (словами), які в них містяться.

Які основні принципи LSI?

- Текст подається у вигляді «мішка слів»: тобто, порядок слів у і їх близькість один до одного значення не мають.

- Документ відноситься до тієї чи іншої тематики / групі на підставі термінів (слів), які в ньому містяться і частоти цих термінів (кількості раз, які вони зустрічаються в документі).

- Кожне слово має єдине значення. Це не зовсім коректне припущення, але воно необхідне для побудови моделі.

Що робить LSI?

Аналізує великий обсяг документів і на основі зустрічаються в них слів відносить документ до тієї чи іншої тематики.

Як технічно працює LSI?

фактично це сингулярне розкладання терм-документної матриці, яке дозволяє виловити ключові складові цієї матриці і проігнорувати шуми. Але не будемо про складне і незастосовні, а для бажаючих розібратися пропоную хорошу статтю про LSI на habrahabr .

Що таке LSI, і з чим їдять?Як поставити LSI на службу SEO?

Як застосовувати LSI?

Як поставити LSI на службу SEO?

Однак, як проводити аналіз?

Звідки взяти релевантні слова?

Як оцінити текст на відповідність тематиці?

А що якщо немає?

Що підсвічує пошук?

Але скільки слів ми можемо «витягти» з висвітлює: від 3 до 5?