Повне керівництво по налаштуванню роботів txt на WordPress

- Що таке файл robots.txt у WordPress (і чому він потрібен)?

- Де зберігаються текстові роботи WordPress?

- Яке правило може бути включено до файлу роботів WordPress?

- Як встановити txt роботів у WordPress (3 способи)

- 1. Використання плагіна Yoast SEO

- 2. Використання все в одному SEO-плагін

- 3. Створюйте та завантажуйте файли robots.txt WordPress через FTP

- Як перевірити файл WordPress robots.txt і відправити його в Google Search Console

- Висновок

Для того, щоб рейтинг сайтів збільшувався на сторінках результатів пошуку (SERP), вам слід полегшити роботу ботів пошуковим системам для вивчення важливих сторінок сайту. Встановивши структурований файл robots.txt , роботам буде простіше індексувати важливі сторінки.

У цій статті ми розглянемо:

- Що таке файл robots.txt і чому важливо встановити його на своєму сайті?

- Де зберігаються текстові файли WordPress txt?

- Як створити robot.txt WordPress?

- Яке правило має бути включено до файлу robots.txt у WordPress?

- Як перевірити файл robots.txt і надіслати його Консоль пошуку Google ?

Сподіваюся, після прочитання цього підручника ви зможете налаштувати файл robots.txt на своєму веб-сайті WordPress.

Що таке файл robots.txt у WordPress (і чому він потрібен)?

Коли ви створюєте новий веб-сайт, пошукова система надсилатиме міньйон (або бот) "сканувати" ваш веб-сайт і створювати карти або карти всіх сторінок, які має ваш веб-сайт. Таким чином, пошукові системи будуть знати, які сторінки повинні відображатися при введенні користувачем відповідних ключових слів.

Просто веб-сайт наразі містить більше елементів і це не просто сторінка. Наприклад, WordPress дозволяє встановлювати плагіни, які також мають каталоги за замовчуванням. Звичайно, ви не хочете, щоб плагін або каталог з'являлися в результатах пошуку, хоча зв'язок не існує.

Файл robots.txt надає набір інструкцій для роботів пошукової системи. Вказівка, здавалося, давала сповіщення: «Те, що ви шукаєте, тут. Вам не потрібно входити до іншої кімнати! " Інформація та інструкції в цьому файлі досить зрозумілі і зрозумілі, навіть якщо ви не є людиною, яка розуміє технічні проблеми.

Коротше кажучи, пошукові системи скануватимуть ваш сайт, навіть якщо файл robots.txt не налаштовано. Це не дуже ефективно, якщо ви не активуєте цей файл. Без цього файлу ви дозволяєте боту вказувати весь вміст, і в результаті частини, які ви хочете приховати, відображаються в пошуковій системі.

Крім того, без файлу robots.txt, ви дозволяєте веб-сайту співати багато ботів. Звичайно, це матиме негативний вплив на продуктивність сайту. Незважаючи на те, що це звучить тривіально, ви все ще не можете закривати очі на фактор швидкості сторінки . Швидкість завантаження сайту або сторінки повинна бути основним фактором.

Де зберігаються текстові роботи WordPress?

При створенні веб-сайту WordPress віртуальний файл robots.txt буде автоматично активований і зберігатиметься в основній папці сервера. Наприклад, ваш сайт доступний через yourfakewebsite.com. Ви, безумовно, можете отримати доступ до вашогоfakewebsite.com/robots.txt і переглянути цей файл:

Агент користувача: * Disallow: / wp-admin / Disallow: / wp-includes /

Наведений вище приклад є прикладом найпростішого файлу robots.txt . Символ після User-agent: показує, який бот застосовує правило нижче. Зірочка означає, що правило є універсальним і може застосовуватися до всіх ботів. У цьому випадку файл інформує бота, що бот не може ввійти і досліджує каталог wp-admin і wp-includes . Це, звичайно, має сенс, оскільки два каталоги містять конфіденційні файли.

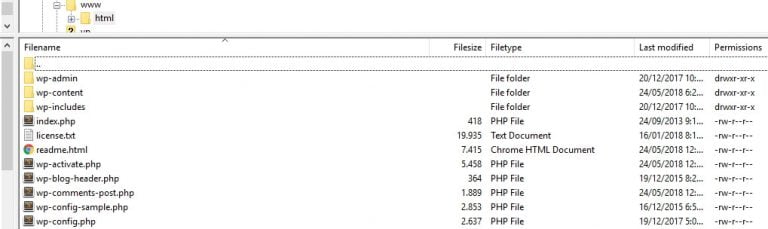

Немає можливості, буде час, коли ви хочете додати більше правил у ваш власний файл. Однак, перш ніж це зробити, спочатку зрозумійте, що robots.txt є віртуальним файлом . Як правило, текстові роботи WordPress знаходяться в кореневому каталозі, який іноді називається public_html або www (або названий за вашим веб-сайтом):

Справа в тому, що файл роботів WordPress txt, встановлений за замовчуванням, не доступний з будь-якого каталогу. Фактично, файл може функціонувати і використовуватись, але якщо ви хочете внести певні зміни, ви повинні створити свій власний файл і завантажити його в кореневу папку в якості заміни .

Ми обговоримо кілька способів створення нового WordPress robot.txt. Але зараз ми обговоримо правила, які треба використовувати в першу чергу.

Яке правило може бути включено до файлу роботів WordPress?

Раніше ви бачили приклад файлу robots.txt, створеного для WordPress. Файл містить лише два коротких правила, але більшість веб-сайтів активується більше. Тепер ми обговоримо різні файли robots.txt і їхні відповідні функції.

Нижче наводиться наш перший приклад WordPress robots.txt :

User-agent: * Дозволити: / # Заборонені підкаталоги Disallow: / checkout / Disallow: / images / Disallow: / forum /

Цей файл є звичайним файлом robots.txt для веб-сайту, який має форум. Іноді пошукові системи індексуватимуть кожен потік у форумі. Однак іноді потрібно активувати файл (це, звичайно, залежить від типу форуму, який ви створюєте). Якщо його вимкнено, Google не буде індексувати сотні потоків, які виконуються лише користувачами з кількома коментарями. Крім того, ви можете також активувати правило, щоб уникнути певних суб-форумів, а також дозволити пошуковим системам "сканувати" решту.

Див. Рядок або рядок Дозволити: / над файлом. Рядок інформує бота, що бот може сканувати всі веб-сторінки, за винятком певних частин, які ви раніше встановили. Крім того, ці правила, які ми встановили універсальними (зірочкою), такі ж, як ті, які виконується віртуальним файлом робота txtWordPress.

Ось ще один приклад роботи robots.txt WordPress:

User-agent: * Disallow: / wp-admin / Disallow: / wp-includes / Агент користувача: Bingbot Disallow: /

У цьому файлі ми встановлюємо типові правила, що й правило WordPress. Ми також додали новий набір правил, які блокують Пошуковий бот Бінга тому він не може сканувати наш веб-сайт. Ми вже знаємо з імені, що Bingbot це ім'я бота.

Ви можете дізнатися, які пошукові боти можуть отримати доступ до вашого сайту, а які - ні. На практиці Bingbot не є небезпечним (навіть не так добре, як Googlebot). Просто ви повинні бути інтроспективним, тому що там ще багато небезпечних і шкідливих ботів.

На жаль, боти не завжди дотримуються вказівок файлу robots.txt . Ви повинні знати, що навіть якщо більшість роботів буде дотримуватися інструкцій, наведених у файлі robots.txt, ви не зможете негайно змусити бота виконати інструкції. Ви лише "просите" дотримуватися інструкцій.

Навіть якщо є багато інформації про те, що дозволено і що заблоковано для доступу до вашого сайту, пам'ятайте, що чим менше правил, тим краще бажані результати. Нижче наведено приклад нашої рекомендації щодо того, як має відображатися ваш перший файл robots.txt :

User-Agent: * Дозволити: / wp-content / uploads / Disallow: / wp-content / plugins /

Як правило, WordPress блокує доступ до каталогу wp-admin і wp-includes . Але, останнім часом, цей параметр більше не виконується . Крім того, якщо ви додасте метадані до зображення з метою оптимізації пошукових систем (SEO), то ви не зможете просто вимкнути його, щоб бот не міг сканувати інформацію на сторінці сайту. Натомість два вищезазначені правила охоплюють те, що потрібно для більшості простих веб-сайтів.

Тільки те, що ви хочете включити в файл robots.txt, залежить від сайту та ваших потреб.

Як встановити txt роботів у WordPress (3 способи)

Вирішивши, що ви хочете включити до файлу robots.txt , наступним кроком буде створення файлу. robots.txt WordPress можна редагувати за допомогою плагінів або вручну. Тут ми розглянемо, як створити WordPress robot.txt з двома з найбільш використовуваних плагінів і кроками для його завантаження.

1. Використання плагіна Yoast SEO

Не потрібно вводити в довжину, майже більшість користувачів вже повинні знати, що це таке Yoast SEO . Цей плагін є плагіном SEO WordPress, який найбільш широко використовується для оптимізації повідомлень і сторінок, використовуючи певні ключові слова. Крім того, плагін Yoast SEO також надає допомогу, якщо ви хочете покращити читабельність вмісту. Зчитуваність показує, чи користувач зручно читає ваш вміст.

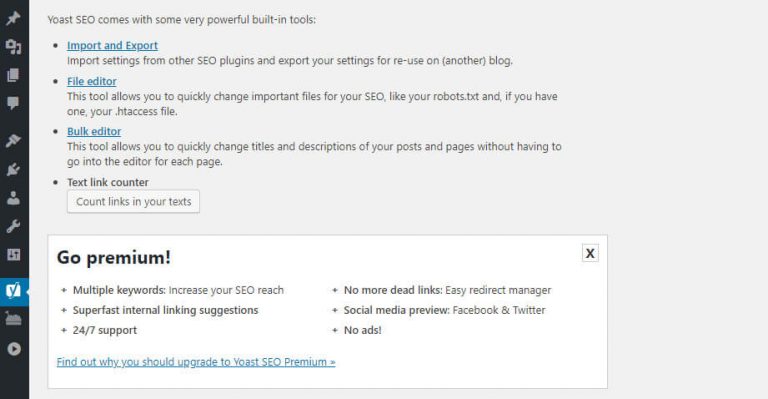

Yoast SEO це плагін, який ми часто використовуємо через його легкість. З цієї причини ми використовуємо цей плагін для створення файлу robots.txt . Після Плагін встановлено та активовано , відкрийте вкладку SEO> Інструменти на інформаційній панелі та знайдіть опцію Редактор файлів :

Натисніть посилання Редактор файлів, і ви перейдете на нову сторінку, де можна редагувати файл .htaccess, не виходячи з інформаційної панелі. Також доступна опція Довідка щодо створення файлу robots.txt :

Натисніть на цю опцію, і ви перейдете до нового редактора, де ви зможете змінити файл robots.txt безпосередньо. Майте на увазі, Yoast SEO має своє власне правило за замовчуванням, яке перекриє або перезапише вже існуючі віртуальні файли robots.txt .

Коли ви додаєте або видаляєте правило, не забувайте завжди натискати Зберегти зміни в robots.txt:

2. Використання все в одному SEO-плагін

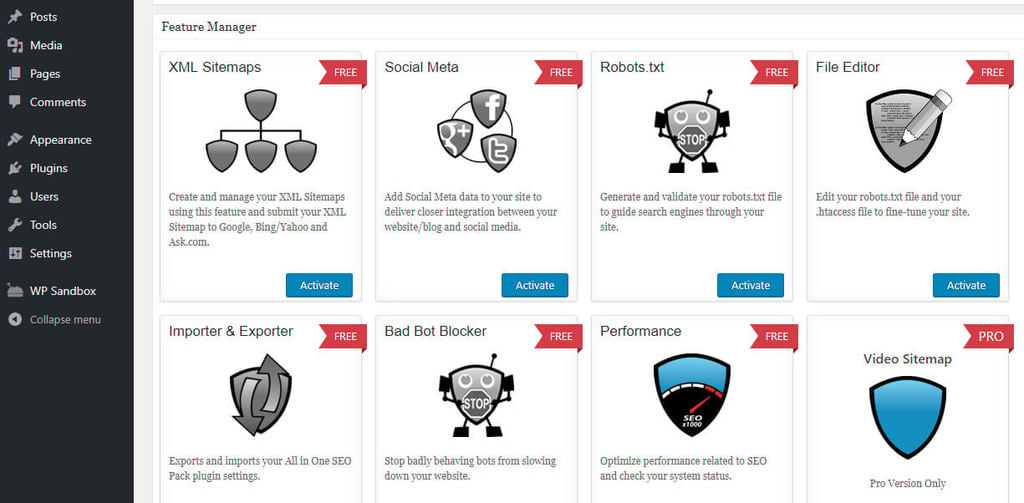

Як встановити текстовий файл робота в WordPress також можна виконати за допомогою додатка Все в одному SEO Pack . Цей плагін пропонує більшість функцій, які також доступні в плагіні Yoast SEO. Тим не менш, є деякі люди, які вибирають плагін Yoast, тому що він легший. Поки ви все ще хочете активувати robots.txt , створення файлів з цим плагіном дуже просте.

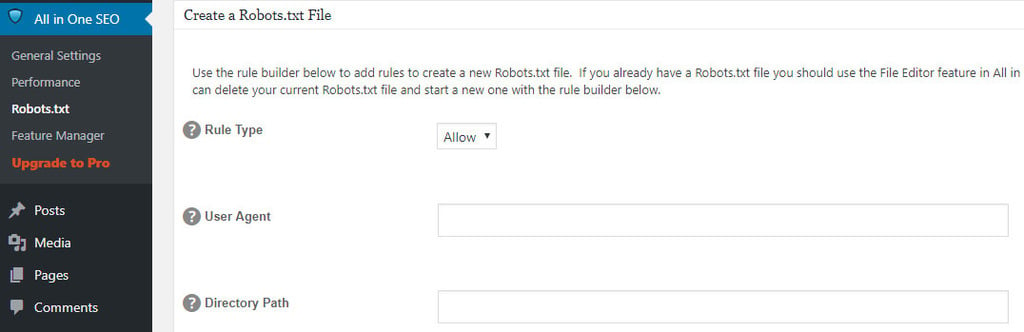

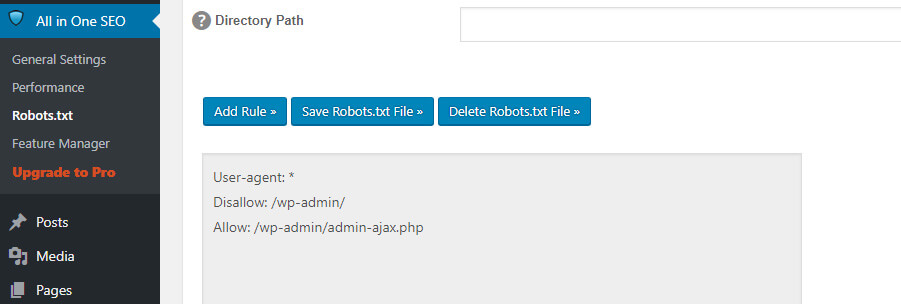

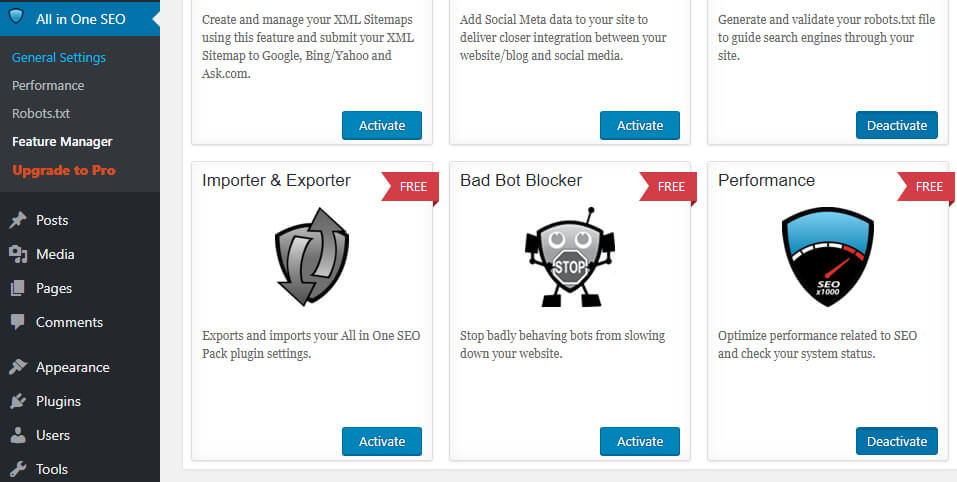

Після активуйте плагін , відкрийте All in One SEO> Керування функціями через панель інструментів. На сторінці ви знайдете файл Robots.txt з параметром Активувати під ним. Натисніть опцію:

Нова вкладка Robots.txt з'явиться у меню " Все в одному" . Якщо натиснути вкладку, ви побачите кілька варіантів додавання нових файлів до файлів, збереження зроблених змін або їх видалення одночасно.

Майте на увазі, що ви не можете безпосередньо змінити файл robots.txt, використовуючи цей плагін. На відміну від Yoast SEO, файли в цьому плагіні неактивні, що дозволяє вводити будь-які потрібні дані:

Додавання нового правила не складно, тому вам не потрібно турбуватися про смертельну помилку. Крім того, все в одному SEO Pack плагін також пропонує функції для блокування бота "шкоди". Доступ до цієї функції можна отримати за допомогою вкладки Все в одному :

Якщо ви не хочете встановлювати і не активувати плагін, ви можете вручну створити файл robots.txt .

3. Створюйте та завантажуйте файли robots.txt WordPress через FTP

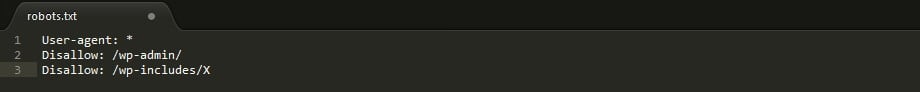

Як зробити txt файл дуже просто. Відкрийте часто використовуваний текстовий редактор (наприклад, Notepad або TextEdit) і введіть кілька рядків. Збережіть файл з будь-яким іменем та у форматі файлу txt . Дивіться, правильно, наскільки легко зробити txt- файл? Таким чином, є можливість, що ви не хочете встановлювати плагін для редагування файлу robots.txt на WordPress.

Нижче наведено приклад одного файлу:

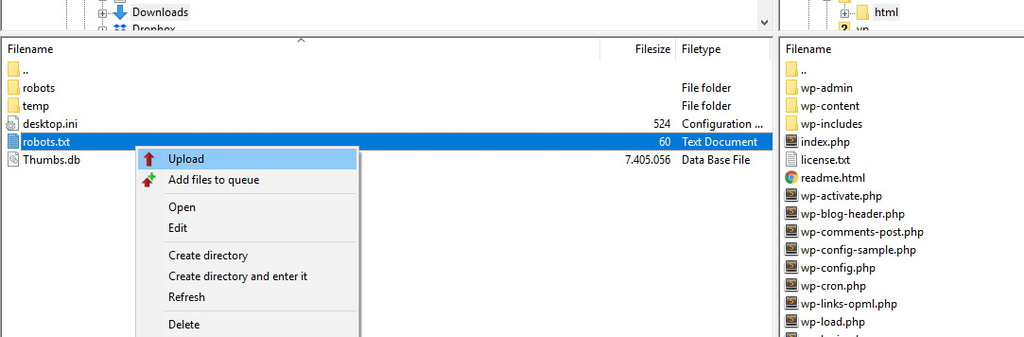

Наприклад, для цього підручника файл зберігається безпосередньо на комп'ютері. Після створення та збереження файлу підключіться до веб-сайту через FTP . Якщо ви не знаєте або не знаєте, як, ми маємо статтю як використовувати FileZilla для початківців .

Після підключення до сайту відкрийте папку public_html, а потім завантажте файл robots.txt з комп'ютера на сервер. Щоб завантажити файл, клацніть правою кнопкою миші на файлі за допомогою локального навігатора FTP-програми або просто перетягніть :

Процес завантаження файлу не займе багато часу. Навіть те, як налаштування txt в посібнику WordPress так само прості, як і при використанні плагіна.

Як перевірити файл WordPress robots.txt і відправити його в Google Search Console

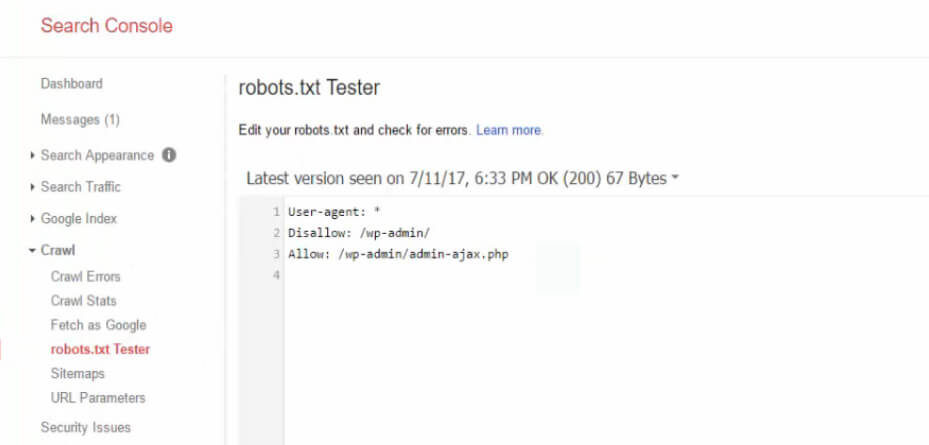

Після створення та завантаження файлу robots.txt у WordPress можна використовувати консоль пошуку Google для перевірки на наявність помилок. Консоль пошуку - це набір інструментів Google, які контролюватимуть відображення вмісту в результатах пошуку. Одним із таких інструментів є перевірка robots.txt , доступ до якої можна отримати після входу в консоль і відкриття вкладки тесту robots.txt :

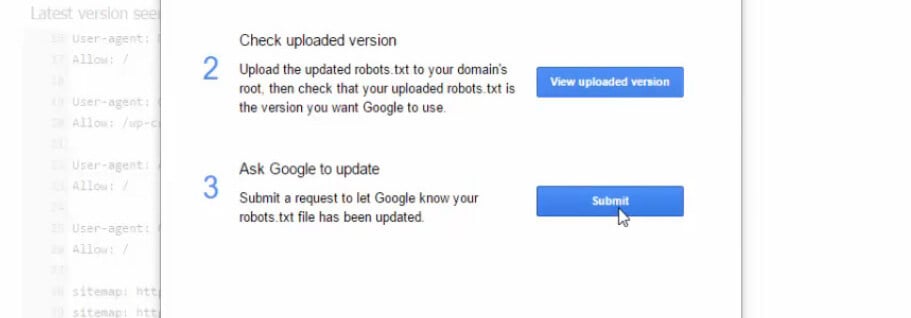

На цій вкладці ви побачите стовпець редактора, який можна використовувати для додавання коду robots.txt до WordPress. Після цього натисніть кнопку " Надіслати ", яка знаходиться прямо під стовпцем. Щоб надіслати код файлу вручну, натисніть кнопку Запитувати Google для оновлення :

Платформа перевірить ваш файл, чи є помилка чи ні. Якщо виникла помилка, платформа надасть сповіщення або сповіщення. Але ми впевнені, що можливість створення помилки з'являється після створення файлу robots.txt WordPress дуже маленький, тому що ви читали поради та кроки вище.

Висновок

Для того, щоб експозиція вашого сайту зростала, встановіть робота пошукової системи на сканування дійсно відповідної інформації. Як ми вже пояснили раніше, добре налаштований файл WordPress robots.txt буде керувати взаємодією ботів з вашим сайтом. Таким чином, боти будуть спрямовувати користувачів на пошук більш інформативного та відповідного вмісту.

Чи є питання, пов'язані з тим, як встановити робот txt на WordPress? Повідомте нас через колонку коментарів нижче.

Txt у WordPress (і чому він потрібен)?Де зберігаються текстові роботи WordPress?

Яке правило може бути включено до файлу роботів WordPress?

Де зберігаються текстові файли WordPress txt?

Txt WordPress?

Txt у WordPress (і чому він потрібен)?

Де зберігаються текстові роботи WordPress?

Яке правило може бути включено до файлу роботів WordPress?

Чи є питання, пов'язані з тим, як встановити робот txt на WordPress?