Seo-аудит сайту за 10 хвилин

Провести seo-аудит сайту за 10 хвилин зовсім не складно, для цього досить слідувати нашій інструкції.

Отже, почнемо з оцінки технічного стану сайту:

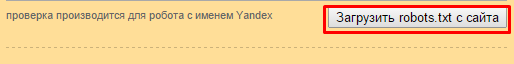

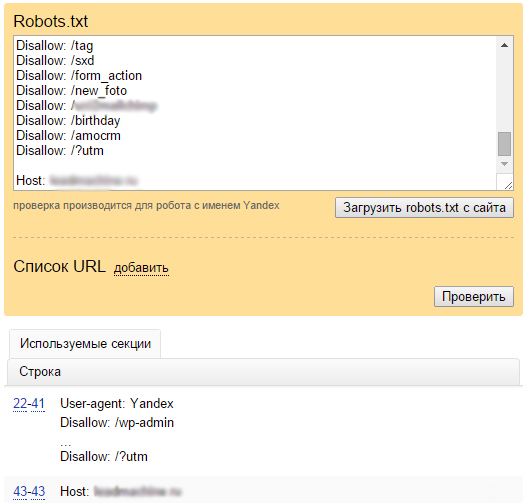

- Robots.txt - важливий файл вашого сайту, що містить інструкції для пошукових машин про те, які директорії потрібно індексувати, а які ні. Заходимо в Яндекс.Вебмайстер - настройка індексування - аналіз robots.txt Натискаємо завантажити robots.txt з сайту.

Після чого система віддає вам весь вміст вашого файлу і виводить можливі помилки.

Після чого система віддає вам весь вміст вашого файлу і виводить можливі помилки.

- Sitemap.xml Файл містить в собі опис структури вашого ресурсу і необхідний для кращої індексації сайту пошуковими системами. Файл слід шукати за адресою: http: //mysite/sitemap.xml.

Якщо файл буде знайдений, то його необхідно завантажити в Яндекс.Вебмайстер і Google Webmaster . Ці сервіси перевірять файл на наявність помилок і напишуть, якщо щось не так. - Наявність помилок в html-коді вашого сайту негативно впливає на ранжування у видачі пошукових систем. Перевірити валідність коду вашого сайту допоможе http://validator.w3.org/

- Проблеми з індексуванням сайту можуть бути пов'язані з тим, як ваш сервер відповідає на запити пошукової машини, відповідь сервера можна перевірити за адресою: http://2ip.ru/server-response/ . Правильною відповіддю сервера є: HTTP / 1.1 200 OK. Детальніше про коди відповіді сервера.

- Дублі сторінок - це дублювання контенту сайту за різними url, тобто коли до однієї і тієї ж сторінці можна звернутися за різними url. Вони також чинять негативний вплив на позиції сайту в видаче.Лучшій спосіб боротьби з дублями - просто не допустити їх індексування, що, на жаль, вдається досить рідко.

Приклади дублів сторінок:

- Коли одна і та ж сторінка відкривається зі слешем і без, наприклад:

mysite.com/page1/

mysite.com/page1

- Сайт відкривається c www і без: http //: www.mysite.ru і http //: mysite.ru

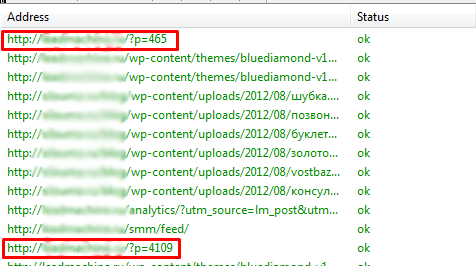

- Технічні дублі, коли система управління генерує адреси виду: http://mysite.ru/?p=426

Допомогти в пошуку дублів по сайту вам може програма xenu

Нами було відмічено, що посилання, розмічені utm мітками, пс Яндекс вважає дублями сторінок.

У разі виявлення у вас дублів рекомендуємо заборонити їх індексацію в файлі robots.txt. Як це зробити - велика тема, тому що у кожна система управління генерує свої дублі і для кожної системи управління robots.txt налаштовується індивідуально.

Почитати докладніше про настройках robots.txt

аналіз контенту

Важливим параметром ранжирування вашого сайту є правильна оптимізація і унікальність вашого контенту.

Title -велику роль в оптимізації сторінок грає мета-тег title, в нього повинні входити ключові слова сторінки. Слова не повинні просто перечісляться- це повинна бути добре сформульована фраза.

Наприклад, для ключових фраз:

- Пластикові вікна в Рязані

- Купити пластикові вікна

Title може бути таким:

Купити пластикові вікна в Рязані за вигідною ціною

Заголовки сторінок - заголовок h1 є наступним за важливістю тегом після title. Він також повинен містити входження ключових слів. Заголовки на сторінці повинні бути розташовані в ієрархічному порядку h1-h2- h3 і т.д.

Унікальність контенту вашого сайту

Низька унікальність контенту вашого сайту буде розцінена пс як "плагіат" і відсутність нової, корисної інформації, в таких випадку фільтр пошукової системи відображає тільки одну копію документа.

Відбувається це так: система розміщує найбільш унікальний контент вгорі видачі і найменш унікальний контент - внизу видачі, в залежності від відповідності контенту пошуковому запиту користувача. Тобто в верхніх позиціях видачі будуть перебувати сайти з найбільш якісним контентом. До ресурсів з не унікальним контентом падає рівень довіри, такі сайти втрачають позиції у видачі.

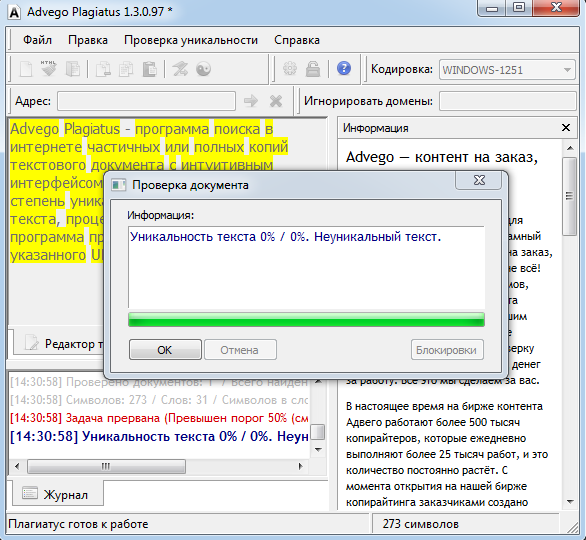

У визначенні унікальності вашого контенту вам допоможе програма Advego plagiatus . Програма має досить прості настройки і вам не важко буде розібратися з нею самостійно.

Важливо знати, що при перевірці в advego plagiatus потрібно орієнтуватися на число 90%, тобто схожість тексту не повинна перевищувати 10%.

Зовнішні чинники

Зовнішня посилальна маса - це кількість посилань на ваш сайт.

На даний момент Посилальне просування є найбільш популярним видом просування, за винятком Москви (В Москві в ряді тематик пс Яндекс перестав вважати кількість посилань ключовим фактором просування).

Аналіз посилальної маси - копітка робота. З безкоштовних інструментів рекомендую використовувати для цієї роботи панель інструментів Google Webmaster .

На що слід звертати увагу при аналізі посилальної маси?

- Наскрізні посилання - посилання, які йдуть з усіх сторінок сайту-донора, наприклад, посилання в меню. Такі посилання надають поганий вплив і знижують авторитет сайту (в Google), особливо якщо мають нерозбавлену входження.

- Донори з однієї підмережі - такі посилання також є підозрілими, так як багато майстрів спеціально створюють сайти-супутники (сателіти).

- Ресурси, які мають сильні зв'язки з вашим сайтом - зазвичай це дочірні інтернет-магазини, що посилаються на батьківський ресурс зі сторінок-карток товару.

- Спамние посилання - посилання, що ведуть з заспамленності ресурсів. Заспамленності ресурсами прийнято вважати сайти, метою створення яких була торгівля посиланнями.

- Посилання низької якості - це посилання, що ведуть з непроіндексованої ресурсів і ресурсів, заблокованих антивірусними програмами.

- Комерційні посилання - пошукові системи намагаються відстежити посилання, куплені на посилальних біржах з метою маніпулювання пошуковими алгоритмами.

Тому намагайтеся відстежувати якість подібних донорів. Одним з явних сигналів вважається ситуація, коли посилання має пряме входження ключового слова.

Необхідно також приділяти увагу аналізу анкоров посилань.

Анкор повинні бути природні:

- Мати розбавлені входження

- Мати брендові входження

- Мати входження в вигляді зображень.

- Посилання із закритою індексацією

- Посилання з входженням title акцептора.

огляд трафіку

Увійдіть в панель інструментів сервісу semrush , Введіть адресу свого сайту, перед вами відкриється графік органічного і платного трафіку, популярні ключові слова і топ-5 ваших конкурентів.

На що звертати увагу

- трафік зростає

- Стоїть на місці

- Були падіння, після яких трафік так і не став рости

Якщо в першому випадку все нормально, то пункт номер два змусити думати, що робити в напрямку зростання трафіку, а пункт номер змусить задуматися, чи не потрапив сайт під фільтр пошукових систем.

До цього моменту у вас повинно складеться думка про проблемні місця вашого сайту, і про те в якому напрямку необхідно працювати. У висновку хочу відзначити, що проводити ці маніпуляції необхідно регулярно, хоча б один раз в три місяці. Важливо розуміти що seo-аудит є важливою частиною аналітики сайту .

А що б перелік робіт з аудиту був завжди перед очима, ми зробили для вас невеликий чек лист .

Ru/?На що слід звертати увагу при аналізі посилальної маси?