Використовувати SEO просування сайтів чи ні?

Сьогодні я хочу трохи поміркувати про таку тему, як SEO просування і пошукова оптимізація сайтів. Потрібно і чи корисно це для сучасних Інтернет-проектів?

Якщо підійти до відповіді на це питання творчо, то своє ставлення до ситуації я можу виразити таким чином:

Жив собі на світі майстер.

Майстер сайтів Олексій

Дні і ночі він намагався,

Робив "сайти для людей"

Якось до мудреця прийшов

І запитав він: Дока,

SEO - це добре

Або - це погано?

Так мудрець сказав йому:

Розумієш, Леха ...

Поведінкові - добре,

А SEO - це погано!

Про те, що таке поведінкові фактори просування (поведінкові) ми поговоримо трохи нижче, а поки хочу сказати ось що: на жаль, навіть зараз можна спостерігати картину, коли дуже багато Інтернет-проекти розкручуються і просуваються якимись напів-шаманськими ритуалами і священнодійством .

Про що це я? Веб-майстри стають заручниками пошукової оптимізації сайту, замість того щоб зосередитися на головному завданні власника ресурсу - написанні якісного і корисного для його читачів матеріалу. Алгоритми пошукових систем весь час удосконалюються і ті методи, які годилися для SEO оптимізації сайту ще вчора, вже сьогодні не працюють. Мало того, застосування оптимізації (читаємо - "штучної накрутки") в минулому, може вже сьогодні призвести до санкцій з боку ПС.

Підтвердження своїх слів я приведу ближче до кінця цієї статті на графіках відвідуваності різних сайтів, а поки б хотів трохи ретроспективно розповісти про те, як виглядало типове SEO просування сайтів років 5-10 тому.

Спочатку для того, щоб сайт потрапив в топ пошукових систем було цілком достатньо взяти і напхати всі статті великою кількістю ключових слів (слів, за якими просувалася кожна з них). Доходило до того, що на перших позиціях видачі були абсолютно нечитабельним і, що набагато гірше, безглузді тексти. Тексти, що не несуть ніякої корисної інформації, але "заточені" під просування і, з точки зору пошукових систем, - релевантні запиту користувача.

Недарма в Інтернеті можна побачити ось такі картинки - відгомони тих часів "дикого" SEO.

Давайте розберемося, чому так відбувалося? Подумаємо ось над чим: яким чином пошуковий алгоритм (по суті - програма) може визначити хороший перед нею сайт чи ні? Очевидно, що за великим або меншій кількості непрямих ознак, доступних йому для аналізу.

Наприклад: кількість символів в тексті, частота ключових слів в ньому, вхідні і витікаючі посилання сайту, час проведений відвідувачем на ресурсі, переходи із соціальних мереж, швидкість завантаження сторінки, аптайм (відсоток доступності) ресурсу і т.д. Бачите, ми самі перерахували декілька варіантів, а у пошукових систем таких ознак (вони називаються "пошуковими сигналами") сотні!

Але на початку 2000-х років пошукові системи тільки "вчилися" відокремлювати зерна від плевел і кількість пошукових сигналів було обмежено, причому, деяким з них віддавалася явну перевагу. Таким чином, володіючи інформацією про те, який з показників потрібно "накручувати", оптимізатор міг відчувати себе королем життя! Ну, якщо не життя, то, по крайней мере, - топа пошукової системи :)

Як ми вже говорили вище, однією з таких "священних корів", яку доїли все, було тотальне заспамліваніе тексту ключовими словами (зараз таке неподобство називається "Переспа ключами" і "переоптімізацію"). Важливі, на той момент, для ПС мета теги «keywords» і «description» також піддавалися масової дискредитації.

Згодом, подібна "оптимізація сайтів" призвела до того, що пошукові системи змушені були припинити довіряти самі собі і почали при ранжируванні враховувати інші критерії. І одним з них стали посилання. Ідея була, і справді, - чудова! Логічно припустити, що якщо на наш сайт посилається велика кількість інших сайтів, то це свідчить про те, що на нашому ресурсі є щось цікаве, він корисний читачам і, як наслідок, гідний перебувати на перших позиціях видачі.

Це - по логіці! За фактом же вийшло так, що дуже швидко в мережі Інтернет все почали масово торгувати посиланнями, стали з'являтися цілі посилальні біржі (агрегатори), де продвігатору (оптимізатора) вже не потрібно було домовлятися з власниками інших сайтів про купівлю або продаж посилань безпосередньо. Він отримував свій віртуальний "кабінет", список сайтів-донорів, які були готові за грошову винагороду розміщувати на своїх ресурсах будь-які посилання, і міг знову відчути, що життя налагоджується :)

Уявляєте, як, в черговий раз, здивувалися розробники пошукових систем, коли виявилося, що дуже скоро і цей, здавався до цього таким логічним і правильним пошуковий сигнал, виявився повністю дискредитований і заспамлен (накручений).

Пошукові системи, в черговий раз, змушені були реагувати. Ось - витяг з офіційної заяви керівника відділу веб-пошуку Яндекса:

Зізнаюся, мені трохи дивно читати зараз заяви маститих SEO-оптимізаторів, які запевняють, що ці зміни, мовляв, стосуються тільки комерційних проектів і на решту видачу не впливають. Ну так! Поки не впливають, але невже не зрозуміло, яким буде наступний крок розробників пошукового алгоритму ?! Знівелювавши вплив зовнішніх посилань для комерційних тематик і випробувавши, таким чином, цей метод, ПС рано чи пізно зробить це і для інших ніш. Це тільки питання часу.

Але навіть зараз, багато оптимізаторів не можуть придумати нічого кращого для просування свого проекту, як "купувати вічні посилання з якісних ресурсів". Звичайно, існують такі чудові речі, як поведінкові фактори, що характеризують поведінку користувача на тому чи іншому ресурсі (скільки часу він провів на сайті, кількість переглянутих їм сторінок, залишений коментар і т.д.) Саме на них зараз все більше орієнтуються Google і Яндекс .

Як Ви думаєте, чому це скоро закінчиться? Правильно! Уже зараз є чергові агрегатори, які займаються накруткою цих самих поведінкових факторів. Продвігатор просто платить гроші за те, що якийсь чоловік перейде на його сайт і буде здійснювати на ньому ряд заздалегідь обумовлених дій: переходити за посиланнями, робити вигляд, що читає статті (скролить їх вниз і вгору), натискати на різні пункти меню в протягом заздалегідь обумовленого часу і т.д. Коротше кажучи, - страждати дурницями! :)

Пам'ятайте, в одній з попередніх статей , Я писав про те, що постійно спостерігаю за розвитком і просуванням деяких проектів в мережі Інтернет? В основному, - це успішні і розкручені сайти. І ось, в кінці 2013-го року (30-го грудня) вирішив я розташувати графіки їх відвідуваності поруч і подивитися на них в порівнянні. Яке ж було моє здивування, коли я чітко побачив загальну тенденцію, яка простежувалася на всіх скріншотах.

Назви сайтів зі скріншотів я видалив, але уважний і наполегливий читач, при бажанні, зможе зрозуміти, до якого проекту який з графіків відноситься :) А тепер, як і обіцяв на початку статті, хочу продемонструвати Вам графіки відвідуваності цих ресурсів, надані сервісом xtool. ru

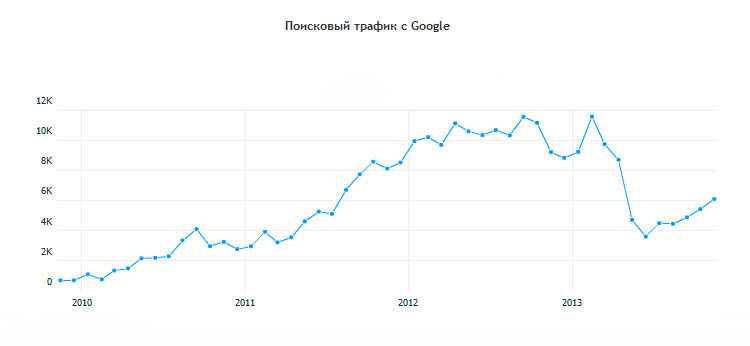

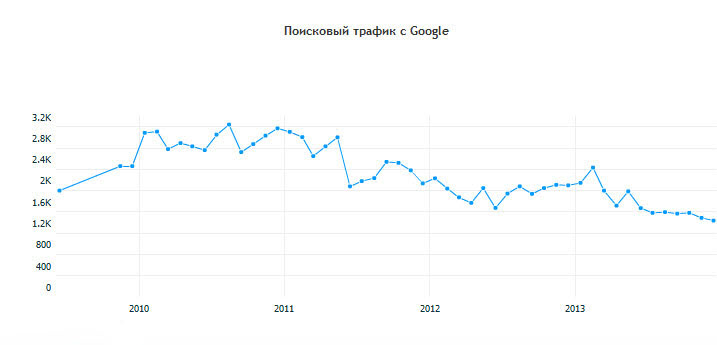

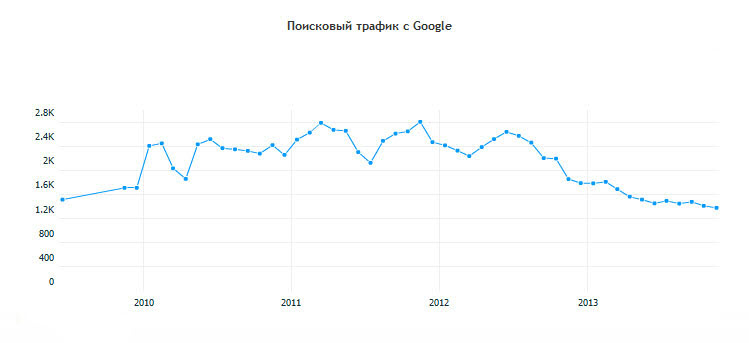

Примітка: зверніть увагу, що графік являє собою динаміку пошукового трафіку сайтів на протязі декількох років (з 2010-го по самий кінець 2013 року років).

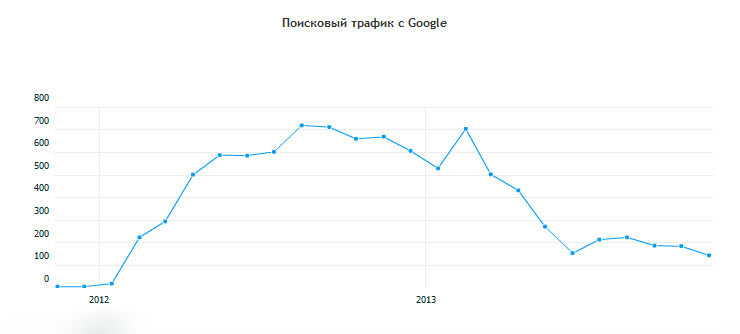

Ось - перший із спостережуваних мною проектів:

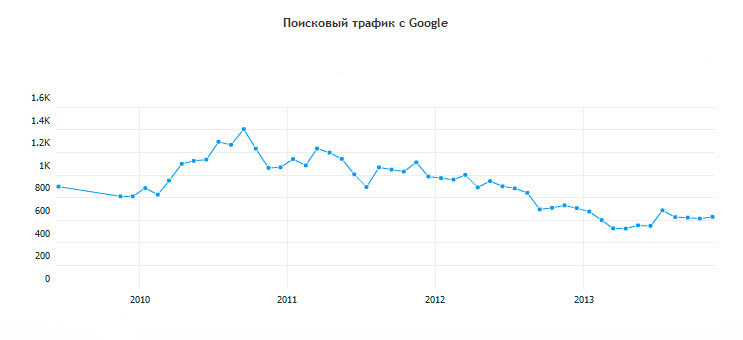

Ось - другий:

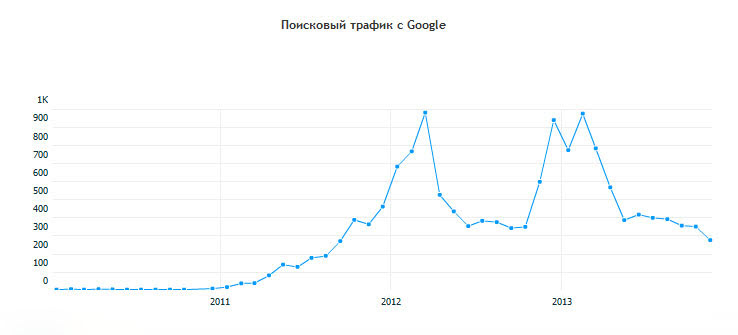

третій:

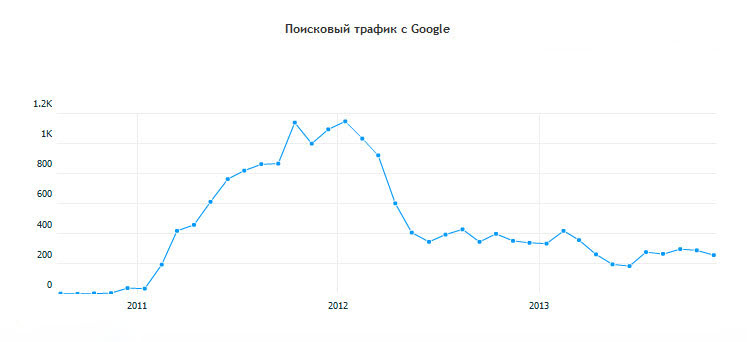

четвертий:

п'ятий:

шостий:

І, нарешті, - сьомий графік:

Чи помічаєте тенденцію? Особливу увагу прошу звернути Вас на зміни в перші місяці 2013 року року, які позначилися на деяких графіках вельми різко. Зі свого досвіду можу однозначно стверджувати, що різкі зміни в пошуковому трафіку можуть свідчити про те, що до сайту були застосовані з боку пошукових систем (в даному випадку - Google) якісь санкції.

Це можуть бути як заходи, прийняті вручну, так і наслідки вступу в дію нового автоматичного алгоритму ПС. Звичайно, з ресурсом можуть трапитися і інші неприємності, наприклад: сайт випаде з індексу , Наслідки атаки вірусу і т.д. Але в даному випад, це не той випадок!

Моя суб'єктивна думка така: всі представлені вище проекти постраждали саме від того, що в минулому активно використовували SEO просування. Пам'ятайте, ми з Вами говорили про поступове заспамліваніі тих йди інших пошукових сигналів? Ось це і є "розплата" за "гріхи" (пошукові накрутки) здійснюються в минулому: масові закупівлі посилань і інші дурниці.

Тому правильно робить Яндекс (думаю, скоро і Google виступить з подібною заявою), що поступово нівелює "священний" для багатьох веб-майстрів показник - вплив зовнішніх посилань.

Виходячи з усього сказаного вище, закликаю Вас, шановні читачі і веб-майстри: чим менше Ви будете використовувати штучне SEO просування сайтів, тим більша ймовірність, що до Вашого проекту ніколи не буде використовуватися ніякі санкції і фільтри з боку пошукових систем. Якщо ж ми починаємо грати в ці небезпечні ігри і думати, що ми - самі розумні, то тільки нам і нести всю повноту відповідальності за можливі наслідки.

Розміщуйте (найкраще - пишіть самі) побільше хороших, корисних для читачів статей, а всієї цієї пошукової оптимізація не заморачивайтесь. Повірте, не в цьому щастя, удачі! :)

Потрібно і чи корисно це для сучасних Інтернет-проектів?Про що це я?

Давайте розберемося, чому так відбувалося?

Подумаємо ось над чим: яким чином пошуковий алгоритм (по суті - програма) може визначити хороший перед нею сайт чи ні?

Поки не впливають, але невже не зрозуміло, яким буде наступний крок розробників пошукового алгоритму ?

Як Ви думаєте, чому це скоро закінчиться?

Пам'ятайте, ми з Вами говорили про поступове заспамліваніі тих йди інших пошукових сигналів?